(以下は、TechCrunchのAIに関する記事を翻訳・要約編集したものであり、元の記事・内容について当社が独自に制作・発信しているものではございません。)

TechCrunch初のAIニュースレターへようこそ。

不定期のコラム「This Week in AI」で提供していたAI業界分析に加え、注目すべき新しいAIモデルのスポットライトもここで紹介していく。

今週のAI業界

今週のAI業界では、OpenAIに再びトラブルが発生した。

OpenAIの元従業員のグループが、ニューヨーク・タイムズ紙のケビン・ルース記者の取材に応じ、彼らが認識している組織内の重大な安全性の欠如について語った。

彼らは、ここ数カ月でOpenAIを去った他の人たちと同様、AIシステムが潜在的に危険な状態になるのを防ぐために会社が十分な対策をしていないと主張し、OpenAIが労働者が警鐘を鳴らすのを防ごうと強硬手段を用いていると非難している。

このグループは火曜日に公開書簡を発表し、OpenAIを含む大手AI企業に対し、より透明性を高め内部告発者の保護を強化するよう求めた。

書簡には「これらの企業に対する政府の効果的な監視がない限り、現従業員や元従業員は、一般市民に対して説明責任を果たすことができる数少ない存在である」と記されている。

悲観的と言われるかもしれないが、元従業員たちのこの訴えは無視される可能性が高いだろう。

AI企業が、署名者たちが推奨するような「オープンな批判文化を支持する」ことに同意するだけでなく、非交渉条項を強制したり、発言することを選んだ現在のスタッフに対して報復したりしないことを選ぶというシナリオを想像するのは難しい。

OpenAIの安全委員会は同社の安全慣行に対する当初の批判に応えて最近設置されたものだが、CEOのサム・アルトマンを含め、全員が同社内部の人間で占められている。

また、アルトマンは一時期、OpenAIの非難禁止条項について知らないと主張していたが、設立文書には自ら署名していることも考慮すべきだ。

もちろん、OpenAIの状況は明日にでも好転するかもしれないが、私は期待してはいない。

たとえそうだとしても、信用するのは難しいだろう。

今週のニュース

AIアポカリプス: OpenAIのAI搭載チャットボットプラットフォームChatGPT、AnthropicのClaude、GoogleのGemini、Perplexityが、今朝ほぼ同時にダウンした。その後、すべてのサービスは復旧したが、ダウンタイムの原因は不明のままだ。

OpenAIが核融合に関心:ウォール・ストリート・ジャーナルによると、OpenAIは核融合スタートアップのHelion Energyとの取引を検討中だ。この取引では、Helionから大量の電力を購入し、データセンターに電力を供給することを計画中だという。アルトマンはHelionに3億7,500万ドルの出資をしており、同社の取締役会にも名を連ねているが、今回の取引交渉からは除外されているという。

データトレーニングのコスト: TechCrunchは、AI業界では当たり前になりつつある高額なデータ・ライセンス契約について取り上げている。この契約により、小規模な組織や学術機関によっては、AI研究が成り立たなくなる恐れがある。

ヘイト音楽ジェネレーター :悪意あるユーザーがAIを利用した音楽ジェネレーターを悪用し、同性愛嫌悪、人種差別、プロパガンダ的な楽曲を作成し、さらに他のユーザーにもその方法を指南するガイドを公開している。

Cohereの現金化: ロイターの報道によると、企業向けのジェネレーティブAIスタートアップであるCohereは、Nvidia、Salesforce Ventures、Ciscoなどから4億5000万ドルを調達した。この資金調達により、Cohereの価値は50億ドルに達したという。TechCrunchによると、OracleとThomvest Ventures(いずれも復帰投資家)もこのラウンドに参加したという。

今週の研究論文

2023年に発表された「Let’s Verify Step by Step」という研究論文で、OpenAIの科学者たちは、スタートアップの汎用生成AIモデルGPT-4をファインチューニングし、数学の問題を解く際に予想以上のパフォーマンスを達成したと主張している。

このアプローチにより、生成モデルが軌道を外れにくくなる可能性があると共同著者たちは述べていますが、いくつかの注意点も指摘している。

論文の中で共著者たちは、GPT-4が数学の問題に対する事実や答えを間違えるという「幻覚(hallucinations)」を検出するために、報酬モデルをどのように訓練したか詳述されている(報酬モデルはAIモデルの出力を評価するための特殊なモデルであり、この場合はGPT-4からの数学関連の出力である)。

研究者たちは、GPT-4が数学問題の各ステップを正しく解いたときに報酬を与えるという「プロセス監視」と呼ばれるアプローチを採用した。

研究者たちによると、プロセス監視により以前の「報酬」モデルの技術と比較してGPT-4の数学問題の精度が向上したと述べている。

ただ完全ではなく、GPT-4は依然として問題のステップを間違えることがあった。

また、研究者たちが探求したプロセス監視の形態が数学の領域を超えてどのように一般化されるかは不明である。

今週のモデル

天気予報は科学的な作業のようには感じられないかもしれないが、それは確実性ではなく確率に基づいているからだ。

確率を計算するのに最適な方法は、確率モデルだ。

私たちはすでに、AIが数時間から数世紀にわたる気象予測に使われているのを見てきたが、今度はMicrosoftがこの分野に参入している。

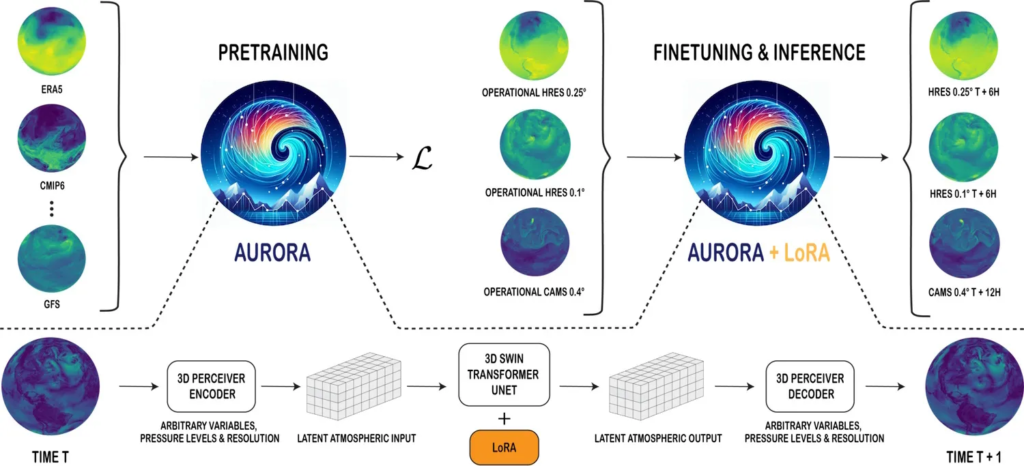

Microsoftの新しいAuroraモデルは、AIの世界で急速に進化する分野での進歩を示しており、地球規模の予測を〜0.1°の解像度(約10km四方)で提供する。

Auroraは、100万時間以上の気象・気候シミュレーション(実際の気象データではない?)でトレーニングされ、いくつかの望ましいタスクに基づいてファインチューニングされており、従来の数値予測システムを数桁凌駕している。

さらに印象的なのは、Google DeepMindのGraphCastを自らのゲームで打ち負かし、1日から5日のスケールでより正確な天気予報を提供していることだ(ただし、Microsoftが得意とする分野を選んでいることもある)。

もちろん、GoogleやMicrosoftのような企業は、最もパーソナライズされたウェブ体験や検索体験を提供しようと、この分野で競い合っている。

正確で効率的な天気予報は、少なくとも我々が外に出なくなるまでは、その重要なピースとなるだろう。

その他

先月、Palladium誌において、AIスタートアップ、Anthropicのチーフスタッフであるアヴィタル・バルウィットは、生成AIの急速な進歩のおかげで、この3年間が彼女や多くの知識労働者が働く最後の年になるかもしれないと主張している。

彼女はこれを恐れるべきことではなく、むしろ安心すべきことだと述べる。なぜなら、それは”物質的な欲求が満たされ、人々が働く必要がなくなる世界”に繋がる可能性があるからだ。

「ある有名なAI研究者は、この転換点に備えて柔術やサーフィンなど、特に得意でないことを始めていると私に話してくれました。上手くなくても、楽しむことを味わう。これは、必要に迫られてではなく喜びのために何かをしなければならない未来に備える方法だと言います。もはや最善を尽くす必要はなくなるかもしれませんが、それでも一日の過ごし方を選ぶ必要があるのです。」

これは確かにポジティブな見方ですが、私は同意できなかった。

もし、生成AIが3年以内に知識労働者のほとんどを代替することになれば(AIの未解決の技術的問題を考えると、私には非現実的に思えるが)、経済崩壊が起こる可能性は十分にある。

知識労働者は労働人口の大部分を占め、高所得者であることが多い。

つまり大きな消費者だ。彼らが資本主義の歯車を動かしているのだ。

バルウィットは、ユニバーサル・ベーシック・インカムやその他の大規模な社会的セーフティネット・プログラムについても言及している。

しかし、連邦レベルの基本的なAI法すら管理できない米国のような国が、すぐにユニバーサル・ベーシック・インカム制度を採用できるとは思えない。

私の考えが間違っていることを願うばかりだ。

出所:https://techcrunch.com/2024/06/05/this-week-in-ai-ex-openai-staff-call-for-safety-and-transparency/